LLM開発でもAPI連携って普通のWebサービスと同じように呼び出せばいいんですよね?

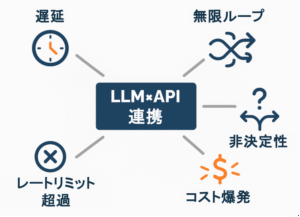

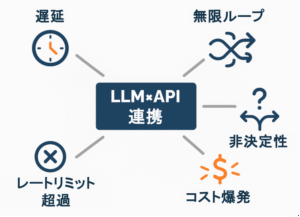

いいえ。LLMとAPIを組み合わせるときは注意が必要ですよ。特にエラー処理とコスト管理は現場で大きな落とし穴になります。

生成AIの普及により、LLMと外部APIを組み合わせたシステムが増えています。検索結果を補足したり、データベースから情報を取得したり、業務フローを自動化したり──可能性は無限大です。

しかし「ただAPIを呼び出せば済む」と思って設計すると、予期せぬエラーやコスト爆発に直面します。本記事では、筆者が現場で実際に遭遇した課題を整理し、再現性のある対策を紹介します。

LLMとAPI連携の背景と課題

LLMは非決定的な応答を返すため、API連携においては従来と異なるリスクが潜みます。以下は代表的な利用場面と、それぞれで生じやすい「具体的な注意点」を整理したものです。

| 利用場面 | 連携するAPI | 主な課題の種類 |

|---|---|---|

| 商品検索チャットボット | ECサイトAPI | レスポンス遅延・在庫同期ミス |

| 業務システム自動化 | 社内REST API | 権限管理・トランザクション整合性 |

| データ要約・検索補助 | Web検索API | レート制限・コスト増大 |

商品検索チャットボット × ECサイトAPI

LLMが生成した商品名の表記ゆれにより、検索APIが複数回呼び出されることがあります。さらにEC側の応答が2〜3秒かかると、LLM側の応答時間と合算されて「ユーザーは体感で10秒近く待たされる」こともある、というのが実案件での悩みでした。ここで重要なのは「遅延がUXに直結する」点です。またキャッシュ未整備だと、販売終了品をおすすめしてしまうケースも発生します。

業務システム自動化 × 社内REST API

LLMが曖昧な指示を解釈して「権限外のAPI呼び出し」を試みるケースがありました。適切に認可エラーを返さないと、セキュリティ上のリスクになります。さらに複数のAPIをまとめて叩くとき、途中で失敗した際のロールバック設計を怠ると「一部だけ更新された中途半端な状態」が残り、データ不整合につながります。

データ要約・検索補助 × Web検索API

検索APIは日単位・月単位の利用上限があるため、LLMがクエリを揺らすとリクエスト数が想定以上に増え、すぐにリミットに到達します。特に「曖昧な質問に対して複数の検索クエリを生成してしまう」ケースが多く、結果として利用料が数十万円に膨らんだ事例もあります。

LLM×API連携で起きやすい失敗パターン

筆者が実務で遭遇した典型的な失敗を整理します。

レスポンス遅延が積み重なるケース

社内FAQシステムにLLMを導入し、必要に応じてナレッジAPIを呼び出す仕組みを構築した事例があります。LLM自体の応答生成に3秒ほどかかり、さらに社内APIの応答が5秒近くかかると、合計で8秒以上ユーザーを待たせることになりました。利用者からは「システムが固まったのでは」との苦情が寄せられ、問い合わせ満足度の低下につながりました。

ポイントは、LLMの処理時間とAPI応答時間が単純に足し算になることです。設計時には「全体で何秒かかるか」を必ず意識する必要があります。

エラー処理が不十分で無限ループ

外部翻訳APIとLLMを組み合わせた仕組みでは、一時的に翻訳APIが503エラーを返した際、LLM側が「翻訳に失敗した」と判断して再試行を繰り返しました。停止条件が設定されていなかったため、リクエストが延々と続き、一晩で数百回の呼び出しが発生。API利用料は数千円規模に膨らみました。

教訓はシンプルで、リトライ処理には回数上限と待機時間を設けること。指数バックオフなどの定石を取り入れれば、このような暴走は防げます。

非決定性による呼び出しの乱発

チャットボットで「東京駅を探して」という入力を与えたところ、LLMが返す出力は「東京駅」「東京ステーション」「東京都千代田区丸の内1丁目 東京駅」と揺れました。そのたびに地図APIを別リクエストとして処理してしまい、結果として無駄なAPI呼び出しが発生したのです。

このような問題は正規化のプロセスを挟むことで解消できます。たとえば出力を一度Geo APIに通して、地名を一意のIDに変換してからAPIに渡す設計です。

コスト膨張で運用停止

あるサポートシステムでは「ユーザー質問をLLMで要約 → FAQ検索APIで候補取得 → LLMで回答生成」という流れを設計しました。

一見効率的に思えますが、実際には1件の質問でFAQ検索APIが10回以上呼ばれることがあり、1件あたり平均5,000トークンを消費しました。

月間1万件の利用で数十万円規模の請求となり、システム運用を停止せざるを得なくなったのです。

設計段階で利用量をシミュレーションしておけば防げた典型例です。

レートリミット超過で全サービス停止

旅行サイトで「おすすめプランを自動生成」する機能をリリースしたところ、ゴールデンウィーク初日にアクセスが集中しました。観光APIは「1秒あたり10リクエスト」という上限があったのですが、LLMが同時に20件以上のクエリを生成してしまい、ベンダー側からブロック。

結果として全ユーザーにエラーが返る大規模障害となりました。

事前にレートリミットを調べ、キューイングやキャッシュ戦略を設けていれば避けられた事故です。

LLMとAPIの連携は業務効率を大きく引き上げますが、「従来のAPI設計」の延長線で考えると失敗に直結します。遅延、エラー、呼び出し乱発、コスト増、レート制限超過──どれも現場で実際に起きうる落とし穴です。

本記事では課題編として失敗パターンを紹介しました。次回の記事では、これらを回避するための具体的な解決策(エラー処理の型化、遅延対策、コスト管理手法など)を解説します。ぜひあわせてご覧ください。

Skilligenceは、現場で成果を出すための研修・顧問・教材を提供する実務支援ブランドです。

・研修:要件定義・業務設計・LLM活用などを体系的に学べる実践講座

・顧問:プロジェクト進行や開発体制の課題を継続的にサポート

・教材:独学でも現場スキルを身につけられる学習コンテンツ

実務で使える知識と仕組みづくりを、学びから伴走まで一貫して支援しています。

▶ IT顧問サービスを見る

▶ 研修一覧を見る

▶ 教材一覧を見る(Starter・Advanced公開中)