この案件で使うLLMって、結局は学習データ次第じゃないですか?

確かにデータは重要です。ただし“依存しすぎる”と、後で大きなリスクに直結してしまいます。今日はその辺りを整理してみましょうか。

生成AIや大規模言語モデル(LLM)の開発が進む中で、しばしば見落とされるのが学習データへの過度な依存です。

「大量のデータを用意すれば解決できる」と考えてしまうのは自然ですが、実務の現場ではそれが大きな落とし穴になります。筆者が参画した複数のLLM案件でも、データ偏重の設計が原因でリスクが顕在化したケースは少なくありません。

この記事では、実案件の経験を踏まえて「学習データに依存しすぎない開発の進め方」と、それに伴うリスクマネジメントの考え方を整理いたします。

学習データ万能主義の罠:LLM開発で見落とされる5つのリスク

ドメイン偏りによる性能低下

学習データが一般的な文書に偏っていると、専門分野の質問に対応できず精度が著しく落ちます。

例として医療QAシステムを開発した際、英語ニュース記事を多く取り込んでいたため、「CRP値」などの臨床用語を誤解し、まったく無関係な回答を返しました。

この問題は開発中のテストでは気づきにくく、リリース後の利用現場で初めて露呈します。結果として「役に立たないシステム」と評価され、再学習や専門データ整備に数百時間の追加工数が発生しました。

著作権・利用規約違反リスク

データ収集段階でライセンス確認を怠ると、商用利用時に法的リスクが顕在化します。

実際に、オープンソースのテキストを「自由利用可」と誤解して採用した結果、ライセンス条項に「非営利のみ」と明記されていたため、商用サービスで使えなくなった例がありました。

この場合、データ差し替えには数ヶ月かかり、顧客リリースも延期されました。初期段階での権利確認を怠ることは、納期と信用を同時に失う行為といえます。

モデルのブラックボックス化

「データを大量に入れれば性能は上がるだろう」という発想で進めると、学習の過程が不透明になります。

ある案件では、膨大なWebスクレイピングデータを取り込んだ結果、モデルは高精度の回答を出すように見えました。しかし「なぜその答えに至ったか」を説明できず、顧客監査に耐えられませんでした。

特に金融や医療分野では、説明可能性が欠けるだけで不採用になるため、単なる精度指標ではなく「根拠提示の仕組み」を設計段階から組み込む必要があります。

再現性の欠如

学習データ依存型のモデルは、再学習のたびに結果がばらつく傾向があります。

筆者が関わった案件でも、初回PoCでは高評価だったにもかかわらず、追加学習後に回答傾向が変化し、テストケースが通らなくなりました。原因は、元データが都度更新されていたことにありました。

このように同じ条件で再現できないモデルは、品質保証が不可能です。バージョン管理と追跡性が欠けていると、顧客への説明も成り立たなくなります。

コスト増大

「まずはデータを集めよう」と動いた結果、収集・クリーニングに膨大な工数を費やすことがあります。

あるプロジェクトでは、担当者が半年以上かけて数百万件のデータを収集しましたが、最終的には利用できるのは数%にとどまりました。

PoC段階からデータ中心で動くことは、ビジネス面での致命傷になりかねません。 データの取捨選択基準を設計段階で決めておかないと、投資効果が得られないまま頓挫してしまいます。

実務で頻発する学習データ依存の失敗パターン

学習データに過度に依存した設計は、実務の中で具体的なトラブルとなって表面化します。以下では、筆者が経験・観察してきた代表的な失敗パターンを詳しく見ていきます。

仕様ズレ

発生背景

プロジェクト初期に収集したマニュアルやFAQを学習データとして利用。しかしその後の仕様変更や新機能追加がデータに反映されず、開発チームも気づかないまま進行。

現場での顕在化

リリース後、ユーザから「最新画面の説明と違う」「操作手順が古い」と指摘が相次いだ。顧客説明会では、質疑応答の場でAIが誤回答を返し、プロジェクトメンバーが回答不能に陥る場面もあった。

影響

正答率は大幅に低下し、納品物の品質が疑われる。追加データ収集と再学習で2〜3週間の遅延が発生。顧客の信頼度も低下し、契約更新に影響を及ぼした。

学び

「学習データに最新仕様をすべて反映させる」ことは現実的でない。設計段階でRAGを組み込み、最新版の仕様書やFAQを外部参照できる仕組みが必要。

テスト不能

発生背景

開発効率を優先するあまり、学習用と検証用のデータが分離されていなかった。結果的にレビュー用データが学習済みに混入。

現場での顕在化

テスト環境での正答率は100%を記録。しかし顧客レビューの場で「なぜ完璧なのか」と指摘され調査した結果、学習データに同じ質問文が含まれていたことが判明。

影響

「虚偽の精度を報告したのではないか」と疑念を持たれ、信頼を大きく損なった。追加の検証作業と説明対応に多大な工数が発生。

学び

テストデータは学習データと厳格に分離することが必須。データ管理の仕組みを文書化し、レビュー工程での二重チェックを設けるべき。

過学習

発生背景

社内文書や用語を大量に学習データとして投入。利用者の大半が外部顧客であるにもかかわらず、設計段階で「社内表現への偏り」を考慮しなかった。

現場での顕在化

外部顧客が一般的な用語で質問しても、AIは社内の略語や特殊表現で回答。ユーザから「専門用語が理解できない」「説明が逆に混乱を招く」と不満が続出。

影響

顧客満足度が低下し、利用率が大幅に落ち込む。修正には追加のデータ整備とモデル再学習が必要となり、数十時間単位のリソースが費やされた。

学び

学習データの偏りを避けるには、利用者層に即した表現を意識的に含めることが不可欠。外部データ参照を標準機能とする設計も効果的。

セキュリティ懸念

発生背景

開発スピードを優先し、匿名化処理や個人情報フィルタリングが不十分なまま社内ログを利用。

現場での顕在化

リリース直前、法務部門から「PII(個人識別情報)が含まれている」との指摘。サービス公開を直前で中止せざるを得なくなった。

影響

予定していた納期が半年遅れ、追加のデータマスキングやセキュリティ検証コストが発生。顧客に対する説明責任も重くのしかかった。

学び

個人情報や機密情報は、データ収集段階で必ずフィルタリング・匿名化を行う。PoC段階からセキュリティ部門を巻き込み、リスクを早期に洗い出すことが重要。

属人化

発生背景

データ収集や前処理のノウハウが特定メンバーに依存していた。文書化や共有が後回しにされ、ブラックボックス化が進行。

現場での顕在化

キーパーソンが異動した直後、誰も処理フローを理解できず、学習データの更新が完全に止まった。新メンバーは復旧に数週間を要した。

影響

プロジェクト進行が停滞し、追加コストだけでなく納期遅延も発生。顧客から「体制に問題があるのでは」と不信感を持たれた。

学び

データ処理の流れを必ずドキュメント化し、複数人でレビュー・引き継ぎできる体制を構築する。属人化は技術的問題よりも先に組織的リスクを招く。

リスクを抑えるための開発指針と運用設計

学習データは重要な要素ですが、それだけに頼るのではなく、開発工程全体でリスク分散を行うことが肝要です。

要件定義の工夫

最初にやりがちなのは「データを集めればなんとかなる」と要件に書いてしまうことです。

例えば、ある案件で「FAQ精度80%以上を目指す。そのために十分なデータを収集する」とだけ記載しました。結果どうなったかというと、半年後に追加機能が出ても要件文書には反映されず、古いデータを集め続けて精度は上がらないままでした。

正しい書き方の例

- 「FAQ精度80%以上。ただし学習データのみで達成するのではなく、最新のFAQシステムを外部参照できる仕組みを前提とする」

- 「応答には必ず根拠リンクを添付すること」

こう書くことで、「データ収集だけでは解決できない」「参照設計も要件の一部だ」という姿勢を最初から示せます。

設計の工夫

設計段階で重要なのは「どこまでを学習に任せ、どこからを外部参照に任せるか」を明確にすることです。

実際の例

ある社内システムでは、すべてを学習データに頼って設計したため、新しい規程が発表されるたびに再学習が必要になりました。1回の再学習に数十時間と数十万円がかかり、運用チームは疲弊。

回避策

- RAGを前提にし、マニュアルや最新規程は都度参照する。

- インデックス作成時に「改定日」「所管部門」をメタ情報として持たせる。

- プロンプトやモデルのバージョン番号を付け、リクエストIDと紐付けてログ化する。

こうしておけば「なぜこの回答なのか」を後から説明でき、監査や不具合調査にも耐えられます。

テストの工夫

テストでは「精度が高いように見えて、実は学習データに答えが含まれていただけ」という罠がよくあります。

失敗例

検証用の質問リストをそのまま学習に混ぜてしまい、テスト結果は正答率100%。顧客レビューで「なぜそんなに完璧なのか」と追及され、信頼を失いました。

回避策

- 学習データとテストデータを物理的に分ける(フォルダやDBレベルで)。

- テスト用には「最新マニュアルのうち公開前に使っていない章」を利用する。

- 評価指標は「正答率」だけでなく「根拠提示率」「回答の一貫性」も含める。

これにより「本当に現場で使えるか」を可視化できます。

運用の工夫

運用は「回す仕組み」を作っておかないと、すぐに属人化して止まります。

現場での失敗例:

データ更新を一人の担当に任せていた案件では、その人が休職した途端に更新が止まり、半年後に「回答が古すぎて使えない」と現場からクレームが続出。

実践的な工夫:

- 更新手順をドキュメント化(「誰が、いつ、どのファイルを更新するか」まで明記)。

- チームで週1回レビューし、「更新したデータは本当に最新か」をチェックする。

- 運用KPI(正答率、根拠提示率、無回答の適切率)を定め、定期的にモニタリングする。

初心者でもまずは「データ更新を1人に任せきりにしない」「最低限のKPIを見える化する」から始めれば、トラブルを大きく防げます。

LLM開発では「データをたくさん集めれば精度は上がる」という思い込みがつきまといます。

しかし実務では、学習データに頼り切ることで精度の低下・ライセンス問題・説明不能・再現性欠如・運用コスト増といったリスクが次々に表面化します。

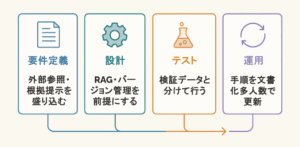

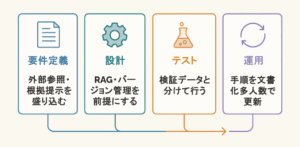

重要なのは、学習データを「万能の解決手段」とみなさず、要件定義・設計・テスト・運用の各段階でリスクを分散させることです。

LLM開発になれない方でも、

- 要件には「外部参照」や「根拠提示」を盛り込む

- 設計ではRAGやバージョン管理を前提にする

- テストでは学習データと検証データを分ける

- 運用では手順を文書化し、複数人で更新を回す

といった工夫を意識するだけで、大きな失敗を未然に防げます。

学習データを前提にせず、あくまで「活用する道具」として扱う。

この姿勢が、これからLLM開発を始める方にとって最も大切なリスクマネジメントの第一歩です。

Skilligenceは、現場で成果を出すための研修・顧問・教材を提供する実務支援ブランドです。

・研修:要件定義・業務設計・LLM活用などを体系的に学べる実践講座

・顧問:プロジェクト進行や開発体制の課題を継続的にサポート

・教材:独学でも現場スキルを身につけられる学習コンテンツ

実務で使える知識と仕組みづくりを、学びから伴走まで一貫して支援しています。

▶ IT顧問サービスを見る

▶ 研修一覧を見る

▶ 教材一覧を見る(Starter・Advanced公開中)